읽으시는 독자님들 중 챗GPT와 같은 생성형 AI 서비스를 써본 분 계신가요? 요즘은 업무에 챗GPT를 동료나 비서처럼 쓴다는 분들이 꽤 늘었는데요.

생성형 AI 프로그램을 이용하다가 의도하지 않게 개인정보를 유출하는 일이 종종 벌어지고 있다는 조사 결과가 나왔습니다.

베리타스테크놀로지스의 최신 글로벌 조사 결과입니다. 직장 내 생성형 AI 사용으로 인한 위험성을 알아본 것이죠. 이에 따르면, 직장내 생성형 AI를 사용하는 것이 결과적으로 혼란을 일으켜 직원 간 분열이 발생하는 동시에 민감한 정보 역시 노출된 위험성이 커지고 있는 것으로 나타났습니다.

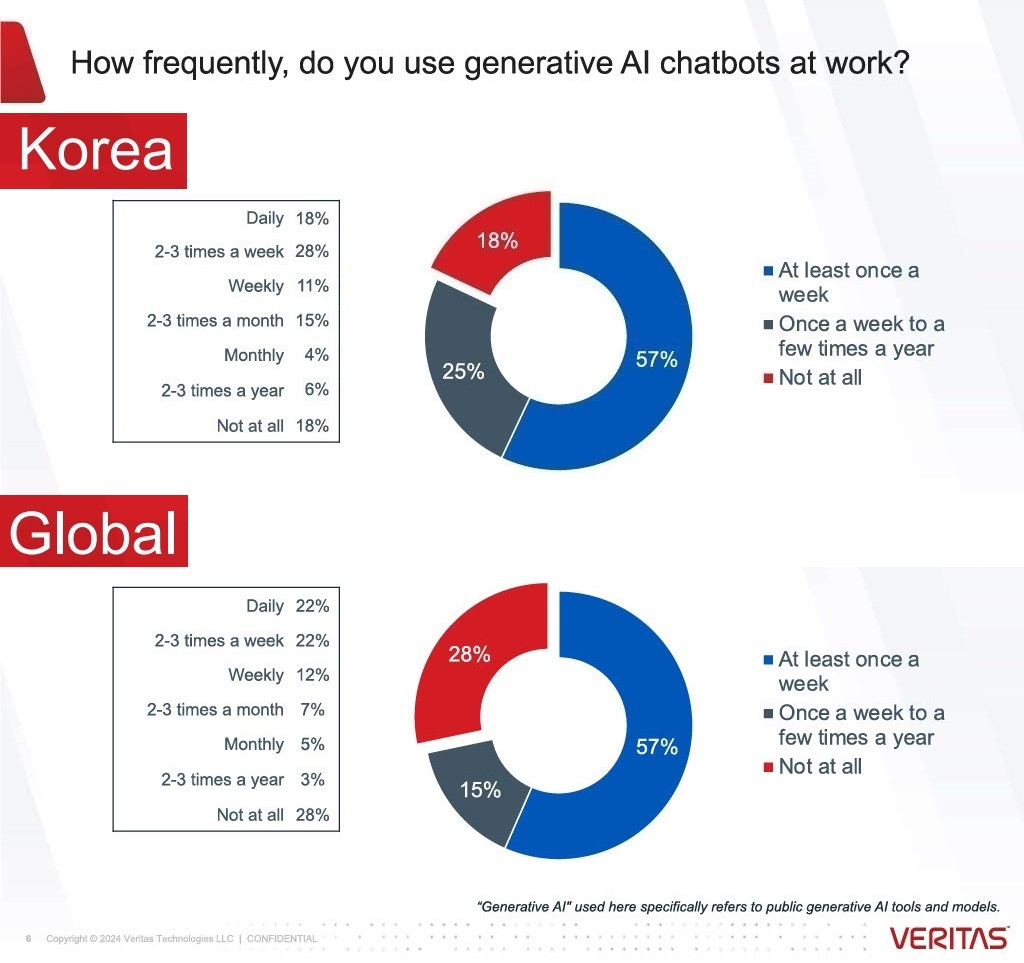

조사과를 좀 살펴볼까요? 국내 응답자들의 내용만 들여다보겠습니다. 먼저 생성형 AI를 얼마만큼 쓰고 있는지부터 확인해 보겠습니다.

전체 응답자의 80% 이상(글로벌 평균 71%)이 업무 중에 생성형 AI 툴을 사용하면서 고객 정보, 직원 정보, 회사 재무 정보를 입력하는 행동을 한 적이 있다고 하는데요.

그런데 이런 행동을 보는 다른 동료들의 눈이 곱지는 않네요. 응답자의 44%(글로벌 평균 53%)가 직장 동료들이 업무에 AI를 활용하는 것이 불공정한 행위이며, 업무 경쟁에서 '부정행위'라고 생각한다고 답했고요.

또, 국내 직장인의 약 절반(46%, 글로벌 평균 39%) 정도가 AI 툴 사용이 민감한 정보를 유출할 수 있다고 생각하네요. 32%(글로벌 평균 37%)만이 이로 인해 '조직이 데이터 개인정보 보호 규정 준수에 위배될 수 있다'라고 생각하는 것으로 나타났습니다.

이렇게 생성형 AI로 인해 조직이 위험에 노출되고 있다고 인지하는데도 불구하고, 실제로 각 기업은 이에 대한 가이드라인을 만드는 데는 움직임이 느려 보입니다.

국내 응답자의 94%(글로벌 평균 90%)는 AI 사용 가이드라인과 정책이 중요하다고 답했지만, 현재 직원들에게 의무적으로 사용 지침을 제공하는 곳은 국내 기업의 40%(글로벌 평균 36%)에 불과한 것으로 조사됐습니다.

따라서 국내 직원의 80%(글로벌 평균 77%)가 조직 내 생성형 AI 사용에 대한 가이드라인, 정책 또는 교육을 제공받기를 원한다고 답했습니다.

왜 가이드라인이 필요하다고 느낄까요? 가장 큰 이유로는 직원들이 생성형 AI가 비즈니스에 미칠 수 있는 위험을 줄이기 위해서(국내 응답자 48%)라고 답했습니다. 또, 적절한 툴 사용법을 배우기 위해서(국내 응답자 40%)라거나 직장에서 공평한 경쟁을 도모하기 위해서(국내 응답자 28%)라는 의견도 있었죠.

이 조사 결과를 어떻게 받아들이면 좋을까요?

베리타스측은 설문결과의 메시지는 분명하다고 말합니다.

1) 생성형 AI의 적절한 사용에 대한 지침과 정책을 신중하게 개발하고 직원들에게 명확하게 전달해야 한다. 2) 또한 이를 올바른 데이터 규정 준수 및 거버넌스 툴 세트와 결합해 그 이행과 지속적인 활동을 모니터링하고 관리하는 것이 중요하다.

기업이 이렇게 움직여야 하는 이유는 분명해 보입니다. 위험 부담은 줄이고, 직원들의 업무 만족도는 올려야 하기 때문이죠. 베리타스코리아 이상훈 지사장은 "이로 인해 직원들의 직무 만족도가 상승할 것이고 조직은 위험 요인의 증가 없이 기술의 혜택을 누릴 것"이라고 강조하기도 했습니다.

참고로 해당 설문조사는 시장조사 업체 3Gem이 2023년 12월 1일부터 12월 13일까지 약 2주에 걸쳐 실시했습니다. 표본은 호주(1,000명), 브라질(1,000명), 중국(1,000명), 프랑스(1,000명), 독일(1,000명), 일본(1,000명), 싱가포르(500명), 한국(500명), UAE(500명), 영국(2,000명) 및 미국(2,000명)의 직장인 1만1,500명으로 구성되었습니다.

콘텐츠 제공 : 바이라인네트워크(byline.network)