주요 퍼블릭 클라우드 서비스 및 데이터 플랫폼 기업들이 앞다투어 ‘딥시크 R1’ 모델을 자사 플랫폼에서 제공하겠다고 발표했습니다. 딥시크가 오픈소스로 공개되어 누구나 다운로드할 수 있기 때문에, 빠른 도입이 가능하다는 점이 그 배경으로 작용하였는데요.

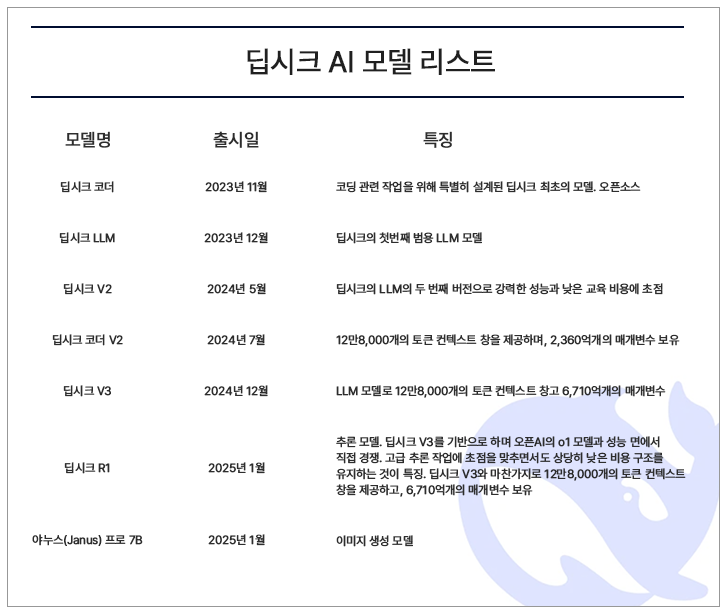

중국 AI 스타트업 딥시크는 작년 12월 대형언어모델(LLM) ‘딥시크 V3’를 출시한 이후 1월 20일 추론모델인 ‘딥시크 R1’, ‘딥시크 R1 제로’, ‘딥시크 R1 디스틸’ 등을 공개했습니다. 이어 1월 27일에 비전 기반 ‘야누스 프로 7B’ 모델을 추가했어요.

가장 먼저 ‘딥시크 R1’ 모델 제공을 밝힌 곳은 MS입니다. 1월 29일 실적 발표에서 ‘딥시크 R1’ 모델을 애저 AI 파운드리와 깃허브에서 사용할 수 있다고 발표했는데요. 이와 함께 MS 시맨틱커널에서 딥시크 모델 사용 지침도 게시했습니다. 개발자는 윈도우 코파일럿 런타임으로 구동되는 코파일럿+PC에서 ‘딥시크 R1’ 모델을 실행할 수 있게 됐죠.

구글 클라우드도 1월 30일 ‘버텍스AI’에서 ‘딥시크 R1’ 모델을 제공하기 시작했습니다. 사티아 나델라 마이크로소프트 CEO와 멧 가먼 AWS CEO가 직접 ‘딥시크 R1’ 제공을 발표한 것과 달리, 구글 클라우드는 조용히 문서 업데이트를 진행했습니다. 구글 클라우드는 공식적으로 ‘딥시크 R1’ 모델 지원을 발표하지 않고, 내부 직원들이 개인적인 미디엄 블로그와 레딧 답변을 통해 ‘딥시크 R1’을 ‘버텍스AI’에서 사용하는 방법을 안내하는 방식을 택했습니다.

아마존웹서비스(AWS)는 1월 31일 ‘딥시크 R1’ 모델을 ‘아마존 베드록’과 ‘아마존 세이지메이커 AI’에서 제공한다고 발표했습니다. 아마존 베드록 마켓플레이스의 모델 카탈로그에서 ‘딥시크 R1’을 검색해 손쉽게 배포할 수 있게 했는데요. 아마존 세이지메이커 점프스타트를 통해 머신러닝 허브에서 클릭 한 번으로 배포 및 활용이 가능합니다. 아마존 베드록 커스텀 모델 임포트를 활용하면 ‘딥시크 R1 디스틸’ 모델을 맞춤형 모델로 가져와 활용할 수 있으며, AWS EC2 Trn1 인스턴스를 사용하면 ‘딥시크 R1 디스틸’ 모델을 AWS 트레이니움 및 AWS 인퍼런시아 기반 인프라에서 실행할 수 있습니다.

엔비디아도 1월 30일 ‘딥시크 R1’을 ‘엔비디아 추론 마이크로서비스(NIM)’로 사용할 수 있다고 밝혔습니다. ‘딥시크 R1 NIM 마이크로서비스’는 단일 엔비디아 HGX H200 시스템에서 초당 최대 3,872개의 토큰을 전송할 수 있습니다. ‘딥시크 R1 NIM 마이크로서비스’는 업계 표준 API를 지원해 배포를 간소화했는데요. 기업은 엔비디아 네모(NeMo) 소프트웨어와 함께 엔비디아 AI 파운드리를 사용해 특별한 AI 에이전트를 위한 맞춤형 ‘딥시크 R1 NIM 마이크로서비스’를 생성할 수 있습니다.

스노우플레이크는 생성형 AI 기반 애플리케이션 생성 도구인 ‘코텍스 AI’에서 ‘딥시크 R1’ 모델을 지원한다고 2월 5일 밝혔습니다. ‘딥시크 R1’은 스노우플레이크 ‘코텍스 AI’를 통해 서버리스 추론에 사용할 수 있는 비공개 프리뷰 형태로 제공합니다. 배치(SQL 함수)와 대화형(파이썬 및 REST API) 모두를 통해 액세스할 수 있어 기존 데이터 파이프라인, 애플리케이션 및 통합개발환경(IDE)에 통합됩니다. ‘코텍스 AI’는 고객이 코텍스 가드를 활성화할 수 있도록 해 잠재적으로 유해한 콘텐츠를 필터링하고, 고객이 생성형 AI 애플리케이션을 대규모로 안전하게 배포할 수 있도록 합니다.

콘텐츠 제공 : 바이라인네트워크(byline.network)